データ分析や機械学習の話題になると、よく次のような声を耳にします。

たとえば、深層学習や勾配ブースティングのように、内部の計算過程が人間には直感的に追いにくいモデルを使うと……

- なぜこの予測になったのか分からない

- もし間違っていたら説明できない

……といった不安が生まれやすくなります。

一方、実務の現場では、こんなやり取りも珍しくありません。

では、ブラックボックスモデルは本当に「悪」なのでしょうか。

それとも、問題は別のところにあるのでしょうか。

今回は、「なぜブラックボックスが嫌われるのか」「どこまでが正当な懸念なのか」「どのように向き合うべきなのか」についてお話しいたします。

Contents

ブラックボックスが問題になるのは「中身が見えないから」ではない

ブラックボックスモデルが敬遠される理由として、よく挙げられるのが「中身が分からないから」という点です。

しかし、実務で本当に困るのは、単にモデルの構造が理解できないことではありません。

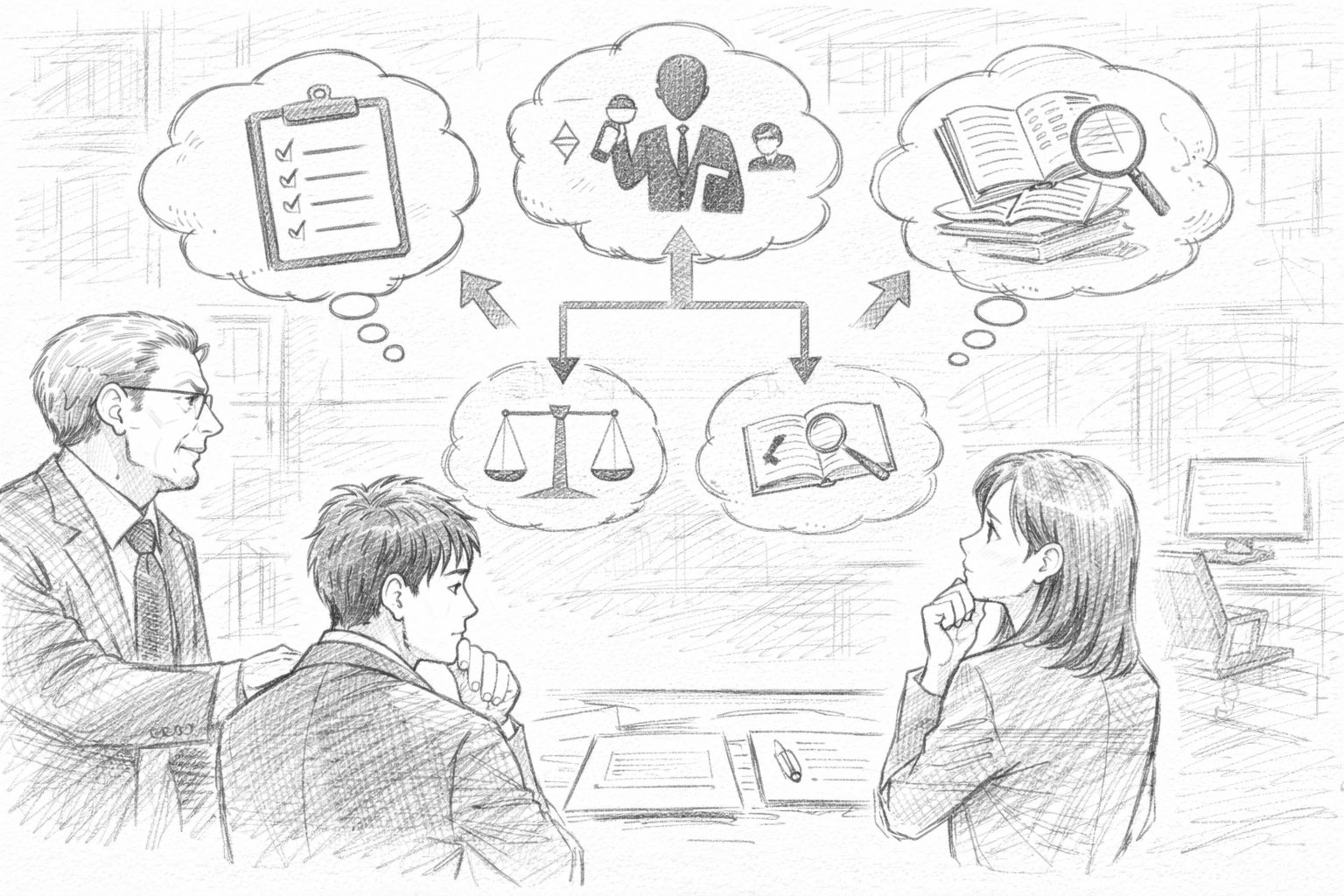

たとえば、次のような場面を想像してみてください。

モデルは「来月は売上が大きく伸びる」と予測している

その結果をもとに、予算配分を決める必要がある

このとき、上司や経営層から、こんな質問が飛んできます。

- なぜ、そう言えるの?

- もし外れたら、どう説明するの?

- この判断の責任は、誰が取るの?

ここで答えに詰まってしまうと、モデルの精度がどれだけ高くても、意思決定には使われません。

つまり問題なのは……

判断の理由と責任を説明できない状態のまま

意思決定に持ち込まれてしまうこと

……なのです。

「ホワイトボックスなら安心」というわけでもない

では逆に、線形回帰や決定木のような「ホワイトボックスモデル」であれば安心なのでしょうか。

たとえば、線形回帰モデルで……

- 広告費が1万円増えると、売上が○円増える

- 価格が上がると、需要は下がる

……といった結果が出たとします。

数式も係数も見えているので、一見すると「説明できている」ように感じます。

しかし、実務では次のような問題が起きがちです。

- その広告費は「どの媒体の、どの施策」を指しているのか曖昧

- 分析に使った期間と、実際の意思決定の期間がズレている

- そもそも前提条件(他施策が一定など)が共有されていない

この状態で意思決定を行うと、「説明できるモデルを使ったはずなのに、判断には使えない」という事態が起こります。

ここから分かるのは、説明可能性とは……

判断に必要な前提・論点・限界が整理されていること

……だという点です。

精度と説明可能性は「どちらか」では決められない

「精度を取るか、説明可能性を取るか」

このような二択で議論されることがありますが、実務では、どちらか一方だけでは不十分です。

たとえば……

- 精度は非常に高いが、理由が一切説明できないモデル

- 理由は説明できるが、予測がほとんど当たらないモデル

どちらも、そのままでは意思決定に使いづらいでしょう。

実務で本当に必要なのは……

どの程度の精度が必要で、

どの程度の説明があれば十分なのか

をあらかじめ考えておくことです。

「完璧に説明できること」も「最高精度であること」も、常に求められるわけではありません。

ブラックボックスが受け入れられる場面の具体例

実務では、ブラックボックスモデルが比較的すんなり受け入れられる場面もあります。

たとえば……

- レコメンドの表示順を少し改善する

- 在庫補充の目安を自動で出す

- 内部業務の効率を上げるための補助判断

このように……

- 判断の影響範囲が限定的

- 多少外れても致命的な影響がない

- 最終判断は人が行う

……といった条件がそろっていれば、「なぜそうなったか」の詳細な説明がなくても、ブラックボックスモデルは受け入れられやすくなります。

一方で……

- 経営判断に直結する

- 社外(顧客・取引先・監査)への説明が必要

- 失敗したときの影響が大きい

こうした場面では、ブラックボックスに対する抵抗が一気に強まります。

重要なのは、モデルの種類ではなく、使われる文脈なのです。

XAIは「ブラックボックスを捨てる」ための技術ではない

XAI(説明可能AI)は、ブラックボックスモデルをホワイトボックスに置き換えるための技術ではありません。

たとえば……

- どの要因が予測に強く影響しているか

- このケースでは、どの特徴が効いているか

- どんな入力のときに予測が不安定になるか

……といった情報を可視化し、人が判断するための材料を補うのがXAIの役割です。

つまりXAIは……

実務で使える形に“翻訳”するための技術

……だと考えると分かりやすいでしょう。

本当に重要なのは「設計思想」

ここまで見てくると、問題の本質はモデル選択ではないことが分かります。

重要なのは……

- 何の判断に使う分析なのか

- 誰が最終判断を行うのか

- どこまで説明できれば十分なのか

これらを、分析の最初の段階で考えているかどうかです。

説明を前提に設計されていない分析は、どれだけ高度な手法を使っても、最後には「使えない分析」になってしまいます。

今回のまとめ

ブラックボックスモデルそのものが、悪いわけではありません。

問題になるのは……

- 説明できないまま

- 重要な判断に使おうとすること

……です。

大切なのは……

その結果を、人が判断できる形に

どう翻訳しているか

……という点にあります。