XAI(説明可能AI)について調べ始めると、次のような疑問が自然に出てきます。

- Excelでできないのか

- BIツールの可視化で十分ではないのか

たしかに、集計・グラフ化・定型レポートであれば、ExcelやBIツールは非常に強力です。

ただ、XAIを単なる「見栄えの良いグラフ」ではなく……

……として運用しようとすると、ExcelやBIでは越えにくい壁が出てきます。

今回は、なぜXAIはPython(やRなどのスクリプト言語)でやるのが現実的なのかについてお話しします。

Contents

XAIの本質は「1枚のグラフを作ること」では終わらない

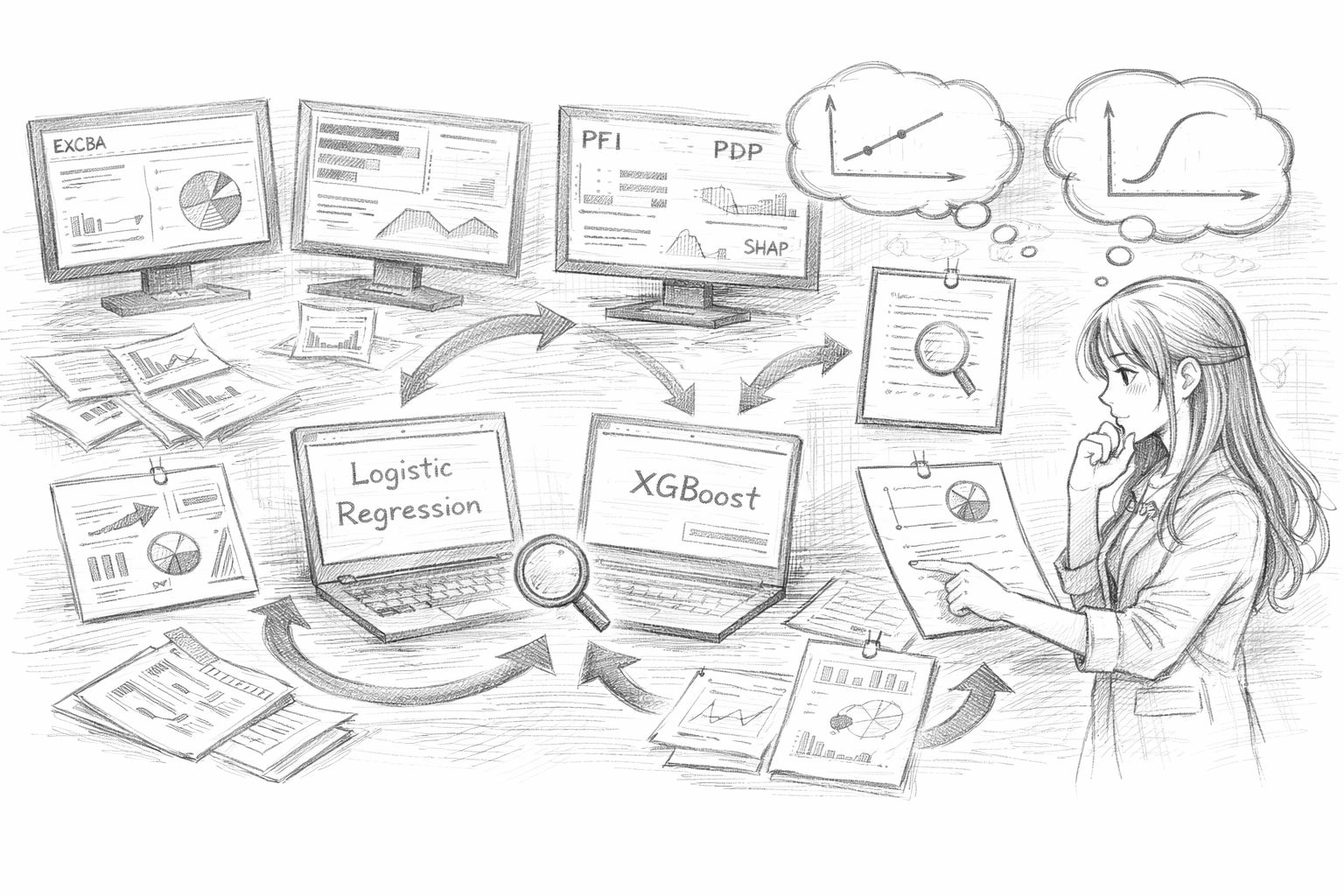

XAIというと、たとえば次のような図を思い浮かべる方が多いかもしれません。

- 特徴量重要度(どの変数が効いているか)

- SHAP値の棒グラフ(寄与度の可視化)

もちろん、これらはXAIの入口として分かりやすいのですが、実務ではそれだけでは足りません。

たとえば、見込み顧客(リード)に対して「セミナー案内」や「営業訪問」を行い、受注確度を予測するモデルを作ったとします。

このとき現場からは、単に「施策の重要度トップ3はこれです」と言われても、こう聞かれます。

- なぜこの顧客は反応したのか?(この1件の説明)

- なぜこの施策は効いたと判断したのか?(判断の根拠)

- 条件が変わったら結論はどう変わるのか?(感度・頑健性)

つまり必要なのは……

……です。

一度作った図を眺めて終わり、ではなく、「条件を変えて確かめる → 追加で説明を作る → 反論に備える」という往復運動が発生します。

ここで、ExcelやBIでは試行錯誤の回数がボトルネックになりやすいのです。

ExcelやBIが苦手になりやすい作業

ExcelやBIツールが得意なのは、主に次の領域です。

- 指標が固定されたダッシュボード

- 定型の集計・グラフ

- 毎月同じフォーマットで更新するレポート

一方、XAIの実務では、次のような作業が頻繁に発生します。

- モデルを入れ替えて比較する(ロジスティック回帰 vs XGBoost など)

- 説明手法を変えて挙動を見る(PFI / PDP / ALE / SHAP など)

- 特定のデータ点だけ深掘りする(「この顧客」の説明)

- 前提条件を変えて検証する(外れ値除外、期間変更、特徴量追加など)

たとえば、重要度が高い特徴量として「Web閲覧回数」が出たとします。

- ある手法では「Web閲覧回数が増えるほど受注確度が上がる」

- 別の手法では「一定までは上がるが、ある点から頭打ち」

このような違いが出ることがあります。

このとき実務では、「どっちが正しい?」ではなく……

- どういう条件で差が出たのか

- どの解釈なら判断に使えるのか

……を確かめる必要があります。

ExcelやBIでも頑張ればできますが、手作業が増えたり、作業が属人化したり、再現が難しくなったりしがちです。

PythonやRが持つ「再現性」という武器

PythonやRといったスクリプト言語でXAIを扱う最大の理由は、結局ここに集約されます。

具体的には、次のような情報をセットで固定できます。

- どのデータを使ったのか(期間、抽出条件)

- どのモデルを使ったのか(学習手順、パラメータ)

- どの説明手法を使ったのか(SHAP、PFI、PDPなど)

- どの条件で評価したのか(分割方法、指標、閾値)

たとえば、実務では次のように聞かれることがあります。

- その説明って、どの期間のデータで作ったの?

- モデルを更新したら結論変わらない?

- 条件変えても同じ説明になる?

PythonやRなどなら、「このコードを同じ条件で回せば同じ説明が再現できます」と言えます。

これは、レビュー・再検証・引き継ぎにおいて極めて強力です。

説明責任は「センス」ではなく「手順」で引き受ける

XAIを実務で使うと、レビューや意思決定の場で、次の問いが必ず出てきます。

- なぜこの説明(このXAI説明手法・可視化結果)を採用したのか

- 別の説明(別のXAI説明手法・見せ方)ではダメだったのか

ここで「なんとなくこの図が分かりやすいから」と答えると、説得力が落ちます。

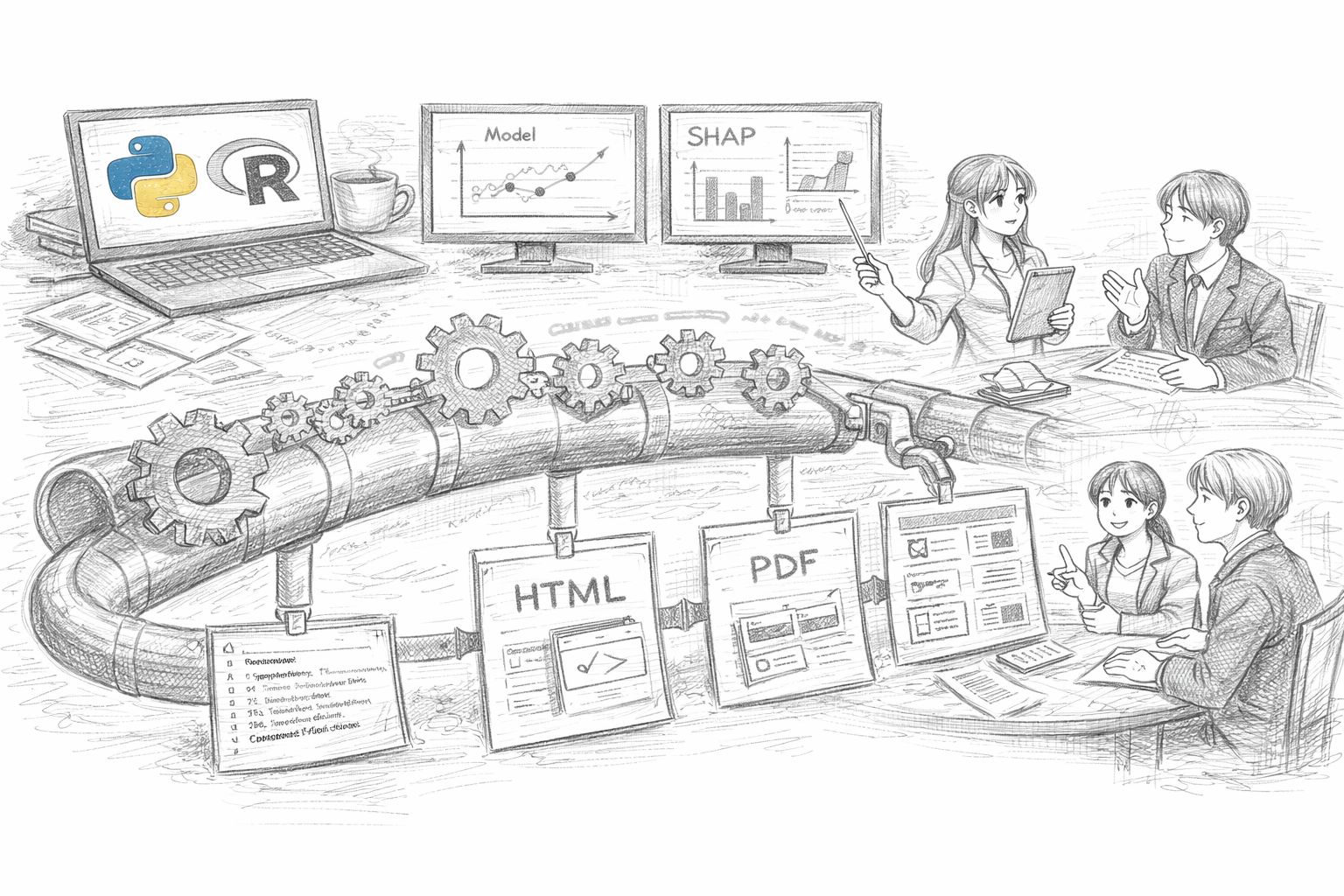

PythonやRなどであれば……

- 別手法との比較

- パラメータ変更

- 前提条件の差分検証

……を、同じコード基盤の上で一気通貫に実行できます。

つまり……

……ということです。

たとえば、次のように複数の角度(XAI説明手法)から整合性を確認できると、「この説明なら判断に使える」という合意形成がしやすくなります。

- PFIではこう見える

- SHAPではこう見える

- PDP/ALEで形状を確認するとこう

PythonやRなどは「説明を作る環境」である

PythonやRは単なる実装言語ではありません。

- モデル構築

- 説明手法の適用

- 可視化

- レポート化(HTML、PDF、Notebook、ダッシュボード等)

これらを一つの流れとしてつなげられます。

XAIの実務で重要なのは……

- 分析(モデル)

- 説明(可視化・言語化)

- 判断(意思決定)

……が分断されないことです。

PythonやRなどは、これらを……

……として機能します。

「PythonやRが難しい」という誤解

ここでよくある反論が、次の一言です。

ただ、実務で本当に困るのは、「PythonやRが難しいこと」そのものではありません。

困るのは……

- 説明できない分析が増える

- 説明の作り直しが属人化する

- 時間が経つと再現できない

……といった、運用上の“詰み”が起きることです。

一度PythonやRでXAIの流れ(前処理→学習→説明→出力)を整えてしまえば……

- 再利用

- 修正

- 改善

……は、むしろExcelより楽になることが多いです。

月次でモデル更新をする場合、Excelで毎回同じ作業を再現するのは地味に大変です。

PythonやRなどなら、「ボタン一つ(=スクリプト実行)で更新」まで持っていけます。

今回のまとめ

XAIは……

- グラフを作るための技術

- 見た目を良くするための手法

……ではありません。

それは……

判断に耐える形に整えるプロセス

……です。

そのプロセスを、再現性をもって回せる環境が、PythonやRといったスクリプト言語です。